Alte Idee neu gedacht

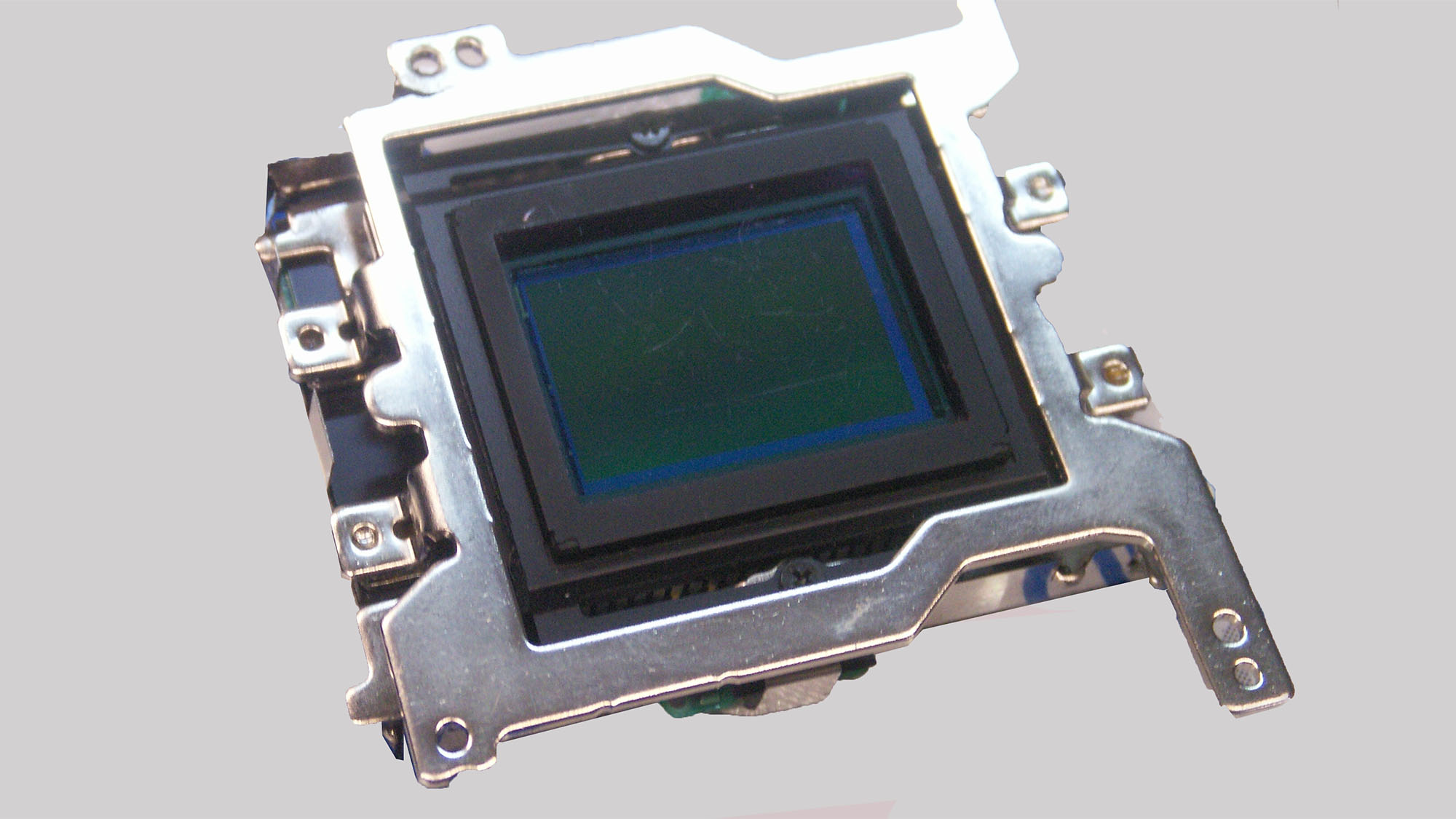

Während analoge Fotoapparate relativ einfach aufgebaut sein konnten und trotzdem sehr gute Bilder produzierten, ist in der Digitalen Kamera jede Menge High Tech erforderlich.Im Zentrum steht der Kamerasensor, eine komplexe Anordnung von Millionen von lichtempfindlichen Halbleitern (meistens aus Silizium), deren Helligkeitsinformationen letztlich ein vollständiges Bild wiedergeben. Damit sie dies tun können, müssen die Informationen mit sehr hoher Geschwindigkeit ausgelesen und an einen Prozessor zur weiteren Auswertung weitergegeben werden.

Das Prinzip hinter dieser Wandlung von Photonen (Lichtteilchen) in Elektronen (elektrische Ladung) nennt man auch den photoelektrischen Effekt. Die Idee, welche dahinter steckt, ist ziemlich alt, sie wurde nämlich bereits Anfang des Zwanzigsten Jahrhunderts für die ersten Vorläufer des Fernsehens erdacht. Erste Prototypen besaßen 100 X 100 Selenzellen als Fotoelemente. Allerdings verfügte man noch nicht über die Möglichkeiten der digitalen Informationsverarbeitung und hätte zehntausende von Kabelsträngen benötigt, um auch nur grobe Umrisse übertragen zu können. Das machte das analoge Verfahren schlicht unrealisierbar. An Speicherung war damals noch gar nicht zu denken.

Intelligente Informationsverarbeitung

Dank moderner Technologie wurde es ab den 80er Jahren des letzten Jahrhunderts möglich, die Helligkeitsinformationen jedes einzelnen Sensors nacheinander auszulesen, wodurch nicht mehr für jeden Sensor eine eigene Leiterbahn oder Verkabelung mehr nötig war. Die damals üblichen Aufnahmeröhren in den Videokameras konnten durch Bildsensoren ersetzt werden. Heute dominieren CCD (Charge-Coupled Device) und C-MOS (Complementary Metal Oxide Semiconductor) Sensoren in unterschiedlichsten Variationen und Baugrößen den Markt.

Dabei ist die schiere Anzahl der lichtempfindlichen Fotodioden, welche man umgangssprachlich auch in Pixeln angibt, längst nicht das entscheidende Merkmal für eine hohe Bildqualität. Die erste digitale Fotokamera im Jahre 1975 besaß aus unserer heutigen Sicht lächerliche 0,01 Megapixel. Das ist sehr weit entfernt von heute üblichen Werten. Die Anzahl dieser Fotodioden berechnet man aus der Anzahl in der Breite, multipliziert mit der Anzahl in der Höhe. Eine handelsübliche Auflösung von Horizontal 5616 Pixeln (Bildbreite) und Vertikal 3744 Pixeln (Bildhöhe) ergibt 21.026.304 Pixel, der Sensor hat also 21 Megapixel.

Das ist allerdings bei Farbaufnahmen noch längst nicht die Auflösung des Bildes, denn wenn es sich nicht um eine 3-Chip Kamera handelt, so werden von diesen vielen Fotodioden jeweils vier benötigt, um die Farbe und Helligkeit eines späteren Bildpunktes zu erfassen. Für die im Videoumfeld übliche Kategorisierung der Auflösung wird die Anzahl der darstellbaren horizontalen Bildpunkte (SD, HD, 2K, 4K, 8K, 12K usw.) herangezogen.

Vor den eigentlichen Schichten mit Fotodioden liegen diverse Filter, darunter Infrarotfilter sowie Tiefpassfilter gegen unerwünschte Moireeffekte. Vor den einzelnen Fotodioden sitzen zusätzlich Mikrolinsen, die helfen, mehr Licht einzufangen. Wenn die Farbinformationen über Bayer-Matrix ausgelesen werden, sitzen vor den einzelnen Fotodioden auch noch jeweils Rot, Grün und Blau Filter. Wichtiger als die Anzahl der Fotodioden sind die Sensorgröße, der Dynamikumfang und das Aufnahmeformat.

Unterschiedliche Grundprinzipien

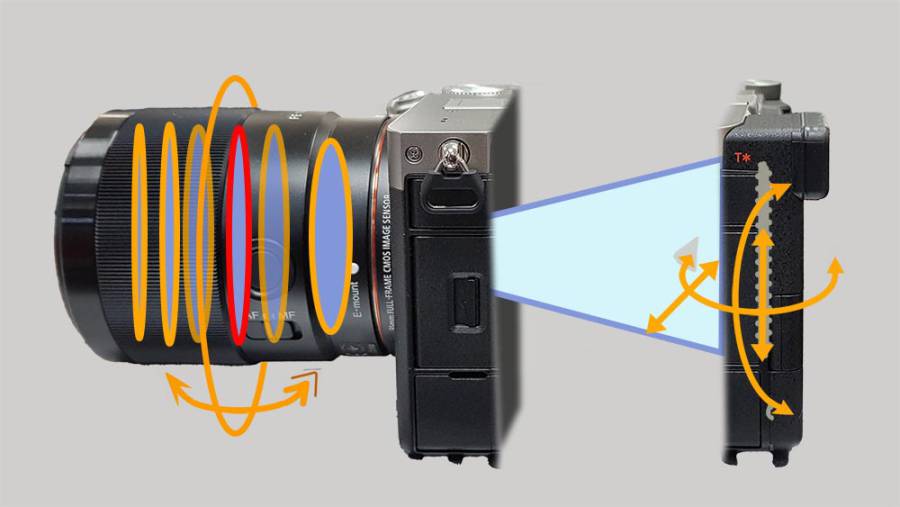

Während die CCD Bildsensoren die Helligkeitsinformationen quasi über horizontale und vertikale Raster weitergeben müssen, was viel Zeit kostet, sind die CMOS Sensoren so konstruiert, dass jede einzelne Fotodiode individuell ausgelesen werden kann. Das macht sie deutlich schneller, deshalb verwenden heute alle hochwertigen Kameras CMOS Sensoren. CMOS Sensoren verbrauchen auch weniger Strom, als CCD Sensoren und neigen weniger zu Streifenbildung bei punktförmigen hellen Lichtquellen.

Doch es gibt nicht nur Vorteile. So können bei der Nutzung des elektronischen Verschlusses so genannte Rolling Shutter- Effekte entstehen. Außerdem verbraucht die zusätzliche Verstärkerelektronik auf dem Sensor Platz und reduziert damit die lichtempfindliche Fläche.

Die Sensorenhersteller begegnen diesem Problem durch einen anderen Aufbau, die so genannte "Back-Side Illumination" oder auch "Rückseitig Belichteter Sensor" genannt. Die Leiterbahnen werden dann hinter die Fotodioden verlegt, wodurch sich die Fläche der Fotodioden und damit auch deren Lichtempfindlichkeit, vergrößert. Man kann sagen, dass hierdurch die verfügbare Empfindlichkeit von BSI Sensoren gegenüber FSI (Frot Side Illumination) verdoppelt wird.

Dual Native ISO

Eigentlich hat jeder Kamerasensor genau eine Empfindlichkeit, ausgedrückt durch den ISO Wert. Diese liegt, je nach Kamera, bei 400 oder 800 ISO. Alle anderen Werte, die man per Menü einstellen kann, also 1600, 3200, 6400 usw. sind lediglich Verstärkungen der elektronischen Signale. Verstärker arbeiten nie völlig unsichtbar, meistens fügen sie dem Bild mehr oder weniger Grundrauschen hinzu, welches irgendwann sichtbar wird.

Nun gibt es aber seit einigen Jahren auch Kameras, die laut Hersteller zwei verschiedene ISO Grundempfindlichkeiten haben, was irgendwie der Behauptung entgegensteht, jeder Sensor habe nur eine Empfindlichkeit. Was genau machen diese Kameras anders, dass sie trotzdem zwei Grundempfindlichkeiten anbieten?

Nun diese Kameras haben natürlich auch nur einen Sensor, das Geheimnis, welches im Marketing als zweite Grundempfindlichkeit verkauft wird, liegt in den analogen Verstärkern. Bevor die Helligkeitsinformationen von den lichtempfindlichen Fotodioden in ein digitales Signal gewandelt werden, werden sie bereits verstärkt. Von diesen analogen Verstärkern gibt es bei Dual Native ISO-Sensoren nämlich zwei verschiedene. Ein Verstärker ist so abgestimmt, dass er möglichst optimale Bildqualität bei den Lichtverhältnissen liefert, welche die Grundempfindlichkeit des Sensors bedienen.

Wenn man auf die höhere ISO umstellt, kommt ein anderer Verstärkertyp zum Einsatz, der so optimiert ist, dass er bei geringeren Lichtmengen ein möglichst geringes Signal-Rausch Verhältnis bietet. Die Kamera schaltet also bei dem höheren Native ISO auf einen anderen Signalweg um, bevor die analogen Informationen in digitale umgewandelt werden.

Zukunft

Für künftige Sensoren gibt es Konzepte und Prototypen, welche über gewölbte Bauformen Abbildungsfehler der Objektive auszugleichen versuchen oder sogar gänzlich ohne Objektive auskommen. Gewölbte Sensoren könnten auf jeden Fall durch die Bildfeldwölbung des vom Objektiv projizierten Bildes auskorrigieren.

Weitere vertiefende Artikel zum Thema:

RAW Pixel Bildauflösung CCD Sensoren CMOS Sensoren Rolling Shutter 4K Sensoren