Digitales Face-Lifting

Von wenigen Jahren noch Science Fiction, dann seltener Aufreger in Täuschungs Videos ist die Deepfake-Technik inzwischen auch in Filmproduktions-Umgebungen angekommen. Schauspieler nutzen die Deepfake-Technik, ein Einsatzgebiet von Artificial Intelligence inzwischen aktiv, um weiter in Filmen präsent zu bleiben.

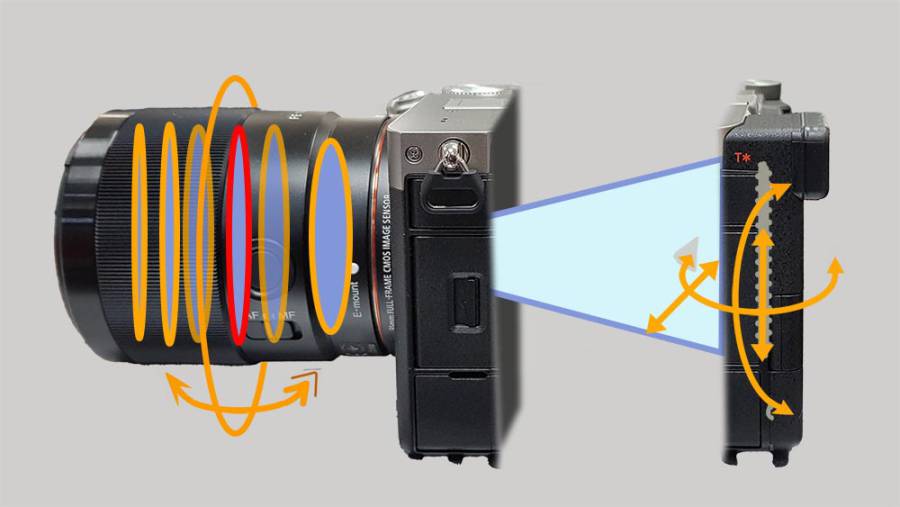

Hierbei werden mit Hilfe von künstlicher Intelligenz (KI) bewegte Gesichter und auch Stimmen von Menschen in Filmen austauschbar. Seinen Ursprung hat der Name dieser Faceswapping - Technologie, in der Pornografie. Etwa um das Jahr 2017 begann ein User, der sich Deepfake nannte, im Internetforum Reddit damit, Gesichter prominenter Schauspieler*Innen in Pornovideos einzumontieren. Im Unterschied zu früheren Compositing-Trickeffekten, werden diese Aufnahmen mit sogenannten Autoencodern automatisch durch Algorithmen manipuliert. Will man hochwertige Ergebnisse erzielen, ist sehr hohe Grafik-Rechenleistung erforderlich.

Digitale Unsterblichkeit

Bruce Willis etwa, bei dem Aphasie diagnostiziert wurde (eine Krankheit, welche die Wahrnehmung und Kommunikationsfähigkeit beeinträchtigt), weshalb er sein Karriere-Ende verkündet hat, verkaufte die Rechte sein Äußeres zu Digitalisieren um als Schauspieler in künftigen Filmen weiterzuleben, an die Firma "Deepcake". Damit können per Deepfake Technologie auch in Zukunft digitale Versionen von Bruce Willis in Werbung und Spielfilm eingesetzt werden, die dann ohne Beteiligung des Schauspielers hergestellt werden.

Dafür hat das Unternehmen Aufnahmen von Willis die für die Filme "Die Hard" und "Das fünfte Element" gedreht wurden, eindigitalisiert. Damit kann das Gesicht von Willis relativ leicht auf die Gesichter anderer Personen, die in künftigen Projekten für ihn stellvertretend spielen, gelegt werden. Das Verfahren kam bereits 2021 mit Willis für eine Werbung einer russischen Telefongesellschaft zum Einsatz. Für künftige Filme und Spots wird Willis dann vermutlich mit einem Spielalter von Anfang 30 bzw. Anfang 40 zu sehen sein. Willis hält aber weiter das Recht an seinem Äußeren und wird stets ein Vetorecht behalten, welche Projekte von ihm durchgewunken und welche abgelehnt werden.

Willis ist nicht der Erste, der digitale Versionen im Film einsetzen will. Bereits Mark Hamill hatte in der Disney-Serie "Das Buch von Boba Fett" einen Auftritt als junge Version seiner selbst per Deepfake. In Star Wars Rogue One hat man zwei bereits verstorbene Schauspieler,- Carrie Fisher und Peter Cushing digital weiterspielen lassen. Will Smith war in dem Kinofilm "Gemini" neben einer jüngeren Variante von sich zu sehen und Sigourney Weaver ist durch die gleiche Technik im neuen "Avatar"-Film von James Cameron als Teenager dabei.

Zukunft der Schauspielkunst?

Natürlich nährt die Technik Wünsche von Filmproduzenten, in naher Zukunft verstorbene Filmlegenden wie Marylin Monroe oder Cary Grant in Filmen wieder lebendig werden zu lassen. Noch ist die Technologie nicht so weit, doch es wird weiter intensiv an derartigen Verfahren geforscht.

Nun könnte sich mancher fragen,- wozu braucht man denn dann künftig überhaupt noch Schauspieler*Innen? Werden die vielleicht irgendwann einfach digital ersetzt? Die Qualität solcher Deepfakes ist höchst unterschiedlich. Je nach Technologie und Rechenaufwand kann es durchaus zu Ergebnissen führen, bei denen die Gesichter seltsam unlebendig wirken, starrer und mit weniger an der Mimik beteiligten Gesichtsmuskeln und leblosen Augen. Von der Vielfältigkeit an Artikulationen in der Stimme ganz zu schweigen. In der computergestützten Animation spricht man da vom sogenannten "Uncanny Valley".

Digitalisierung bedeutet immer Vereinfachung und Informationsreduzierung. Echte Menschen und vor allem großartige Schauspieler*Innen lassen sich nicht einfach per 3D,- oder Archiv- Scan ersetzen. So gibt es also jede Menge gute Gründe, die echten Schauspieler*Innen zu besetzen und das ist auch gut so.

Akustische Deepfakes

Und auch auf der Tonebene werden inzwischen Deals über die weitere Vermarktung einer Stimme abgeschlossen. So hat beispielsweise James Earl Jones, die Stimme von Darth Vader im Star Wars Epos, an Disney die Rechte verkauft, seine Stimme per künstlicher Intelligenz nachzubauen. Der 91 jährige Jones hatte sich bereits 2019 von der Arbeit als Sprecher verabschiedet. Nun wird seine Stimme im Kino weiterleben. Zum Einsatz kommt dabei Technik der ukrainischen Firma "Respeecher", welche ältere archivierte Aufnahmen des Sprechers eindigitalisisierte. Auf diese Weise lässt sich auch mehr Konsistenz mit den älteren Star Wars Filmen herstellen, in denen die Darth Vaders Stimme ja merklich jünger war. Das Verfahren machte man sich auch bei Mark Hamills in der Serie "The Mandalorian" zunutze. Inzwischen kann die Generative KI aus weniger als einer halben Minute originalen Stimmaufnahmen, realistische synthetische Stimmen erstellen.

Vermehrt kommt es auch zu rechtlichen Auseinandersetzungen mit Schauspieler*Innen, insbesondere, wenn deren Stimmen ohne ihr Einverständnis verwendet werden. So ähnelte die Stimme des im Mai 2024 vorgestellten neuen KI Assistenten ChatGPT 40 frappierend der Stimme des KI-Assistenten im Science-Fiction-Film "Her" (Spike Jonze, USA 2013), den Scarlett Johansson spielte. Sam Altman, der Chef von OpenAI-CEO Sam Altman hatte Jonhansson Ende 2023 gefragt, ob sie die neue Stimme von ChatGPT sein wolle, doch sie hatte abgelehnt. Als dann OpenAI seinen neuen Chatbot vorstellte, klang er genau wie die Stimme der Schauspielerin. Diese hat daraufhin über ihre Anwälte erzwungen, diese Stimme wieder abzuschalten. Das Unternehmen erklärte, man habe eine gänzlich andere Sprecherin eingestellt, deren Stimme verwendet wurde und man habe nie die Absicht gehabt, dass diese der Stimme von Scarlett Johansson ähneln solle.